从显卡之王到 AI 芯片霸主,英伟达走了接近 20 年。

业界达成的默契是,尽管都是点燃「炼丹炉」的炉火,但谁拥有的英伟达芯片越多,谁的大模型就仿佛训练得更聪明,因此垄断将近 90 % 算力的英伟达被捧上神坛。

随着美国升级芯片出口管制措施,连带着英伟达中国特供版芯片也被陆续叫停,芯片短缺正在成为中国 AI 行业往前一步的头等大事。

而无论有没有芯片,中国都在积极地推进 AI 行业的发展。

有无芯片,中国都在推进 AI

办法总比问题多,即便没有足够炉火,炼丹师也可以调整 AI 炼丹的方法。

据《华尔街日报》报道,面对一芯难求的情况,中国的 AI 行业正在采取多种策略来维持发展,包括但不限于编写更高效的代码来缩短训练周期,又或者致力于构建更小、更专业的模型,以及采用耗时和能耗更低的训练方法。

报道中提到,国内 AI 独角兽零一万物采用了一种低精度训练模式,主要通过减少模型训练过程中使用的数值精度来降低计算资源的需求和提高训练速度。

打个比方,我们平时在修图时,为了达到最佳的效果,往往需要比较细致地调整亮度、对比度和颜色等,这就像是在训练人工智能模型时使用高精度数据,能够捕捉到非常细微的差别。

然而,有时候我们只需要快速添加一个滤镜,比如怀旧或黑白,就不需要那么多精细的调整。低精度训练模式正是这样,它通过降低数据的精细度来提升处理速度,同时减少对计算资源的需求。

这种模式让我们更专注于图像的大轮廓和主要特征,而不是每一个小细节。

这样做的优势在于,我们可以更快地训练模型,而且不需要那么强大的计算能力。虽然可能会牺牲一些细节,但对于许多实际应用来说,这种精度已经足够。

报道称,这种低精度训练模式在美国被包括 Google 在内的公司广泛使用,能够加速模型的输出。

零一万物的创始人李开复也提到,由于缺乏足够的 GPU 资源,他们不得不开发出更高效的 AI 基础设施和推理引擎,并且,其芯片集群的故障率,即一组连接的芯片无法一起正常工作的频率低于行业平均水平。

随着英伟达占领 AI 大模型算力芯片市场,并借此一度迈入三万亿美元市值俱乐部,国内外暗暗较劲的芯片公司也同样希望在 AI 算力芯片市场分一杯羹。

最典型的一个例子当属中国华为的 Ascend(昇腾)芯片。

在今年 2 月份时,有消息称,英伟达在提交给美国证交会的文件中,首次将华为列为包括 AI 芯片在内的多个领域的最大竞争对手。英伟达创始人黄仁勋也曾公开为华为的 AI 芯片点赞。

中国历来占英伟达销售额的 20% 左右,随着美国管制措施的进一步加剧,华为昇腾芯片为代表的国产 GPU 厂商也正在逐步填补英伟达留下的市场空白。

据悉,目前华为昇腾系列芯片已经被中国科技巨头、国家研究实验室和国家级 AI 数据中心广泛使用。

在 6 月份举行的会议上,江苏鲲鹏・昇腾生态创新中心首席运营官王陶更是透露,在中国的大模型市场中,有近 50% 选择了昇腾技术路线。

不过,想要在英伟达的市场中分得一杯羹并非易事。最近英国《金融时报》曝出,即便是在美国禁令下,英伟达预计在今年依旧能在合理的管制范围内对中国出口 100 万颗 AI 芯片。

为了进一步打开中国市场,英伟达曾推出了一款性能较低的定制版 H20 芯片,与 H100 相比,H20 的性能只有前者的 15%。即便如此,H20 芯片在中国市场依然是领先产品。

百度、阿里巴巴和腾讯等公司在使用这些国内自研芯片来运行他们的 AI 模型,并通过改进工程和算法来弥补先进计算能力的不足,但同时也在研究如何组合不同类型的芯片,以避免对某一种芯片的过度依赖。

如日中天的英伟达,无人不知

几乎全世界的 CEO 都在争取一个见黄仁勋的机会。

AI 发展的三要素不外乎算法、算力和数据,而算力是进入 AI 竞争的敲门砖。以至于马斯克去年在疯狂抢购英伟达 GPU 时吐槽,人是狗都在抢。

这也解释了为什么当扎克伯格在打造 AI 超级军火库时,会因为手握 35 万个英伟达 H100 时而感到格外自豪。

抢购 GPU 的风潮不难理解,谁先掌握更多的 GPU,谁就有可能在百模大战的硝烟中赢到最后。

如果要用黄仁勋的话来说,那就是:

下一个率先登顶下高峰的公司将能够发布开创性的 AI 产品,而紧随其后的公司只能发布一些性能提升 0.3% 的产品。你是想成为引领人工智能革命的公司,还是只想带来一些微小改进的公司呢?

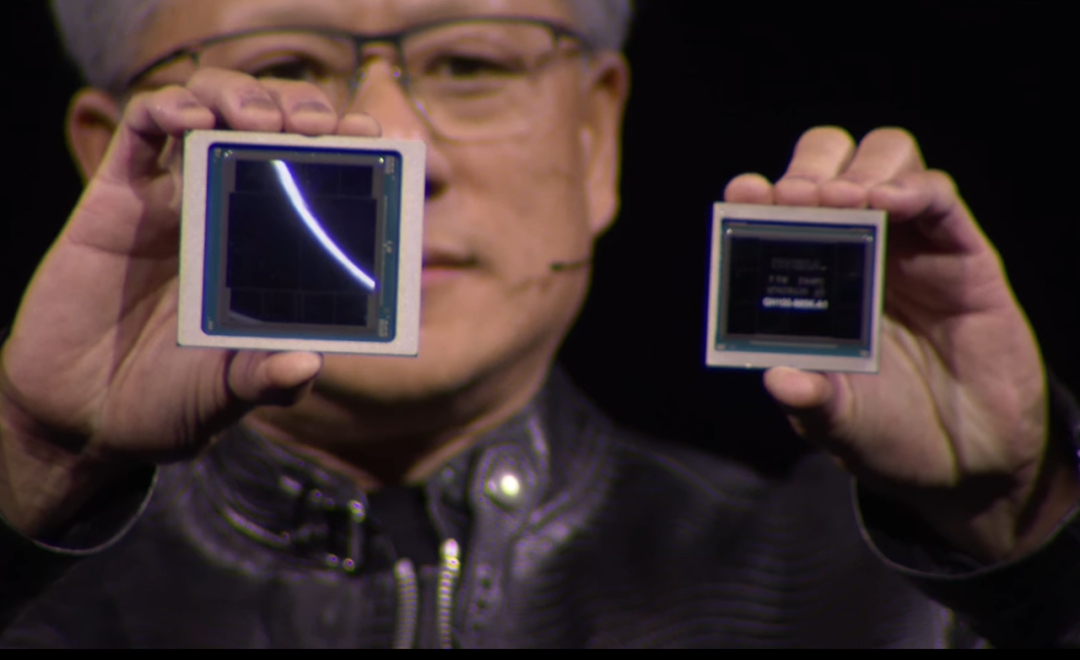

今年 3 月,英伟达正式发布了「地表最强 AI 芯片」Blackwell 架构 GPU。

B200 GPU 拥有 2080 亿个晶体管,采用先进的 4NP TSMC 工艺制造,通过 10 TB/s 的片间互联,将 GPU 裸片连接成一块统一的 GPU。

GB200 的性能也大幅提升,在具有 1750 亿个参数的 GPT-3 LLM 基准测试中,GB200 的性能是 H100 的 7 倍,而它的训练速度是 H100 的 4 倍。

更重要的是,与 H100 相比,它可将成本和能耗降低 25 倍。

站在硅谷巨大的 SAP 中心体育馆,手持 AI 圣火的老黄高呼,加速计算已到达临界点,通用计算已失去动力。

我们需要一种全新的计算方式 —— 由此我们才可以继续扩展,继续降低计算成本,并在保证可持续性的同时继续进行越来越多的计算。与通用计算相比,加速计算使每个行业都可以大幅提速。

两个月后,随着生成式 AI 发展的如火如荼,黄仁勋也隆重宣布英伟达 AI 芯片转向「年更」节奏,这意味着下一代代号为「Rubin」的新架构将有望在 2025 年发布。

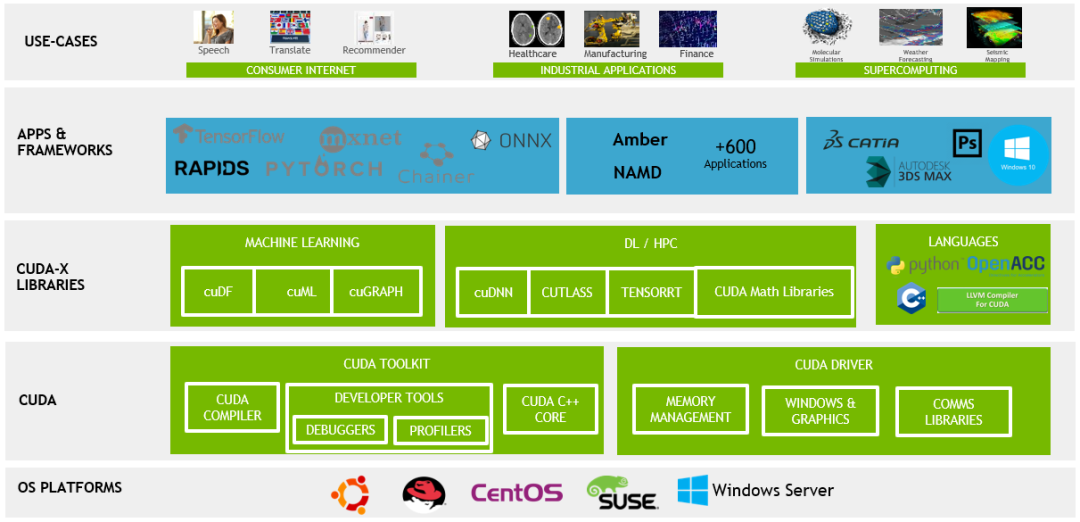

硬件只是基础,软件才是英伟达的核心护城河。

CUDA 是英伟达推出的并行计算平台和编程模型。通过 CUDA,开发者可以编写能够在 GPU 上运行的代码,从而利用 GPU 的并行处理能力来加速计算密集型任务。

黄仁勋不止一次在公开场合表示,没有 CUDA,就未必有英伟达今天在 AI 领域的成功。在他看来,CUDA 可能是现代计算中最重要的发明之一。

Google 前 CEO Eric Schmidt 在最近「全网删除」的视频中透露了不少真心话,其中也提到他曾低估了 CUDA 的重要性,甚至将其比作 GPU 领域的 C 语言。

在他看来,尽管没有公开承认,美国政府实际上禁止了英伟达的芯片出口,而美国在芯片制造领域拥有大约 10 年的领先优势。

并且他还表示,如果前沿 AI 模型继续发展,少数开源模型也参与进来,那么只有少数几个国家有资格参与。这些国家需要拥有大量资金、强大教育体系,并且有取胜决心。

美国是其中之一,中国也是。

而无论是美国还是中国,摆在其面前的第一道拷问都是 AI 的落地应用。

AI 行业正在寻找「白炽灯」

在一个好的市场里,一定有一个能满足那个市场需求的产品。

知名风险投资机构 a16z 的创始人 Marc Andreessen 曾在 《The Only Thing That Matters》 提出上述 PMF (aka product market fit) 这一概念。

将此理念应用于描述当前 AI 行业的发展趋势,似乎同样恰当且贴切。

在上个月的 WAIC 2024,百度 CEO 李彦宏呼吁整个行业不要开卷模型,没有应用,光有基础模型,不论是开源还是闭源都一文不值。

毕马威最近的一份报告也指出,第二季度中国的 AI 投资者正在将目光投向「赋能 AI」 的领域,而非仅仅聚焦于大模型的开发。

根据市场研究公司 Sensor Tower 的数据,今年在美国下载量前十的 AI 应用中,有三款是由中国公司开发的,分别是位列第三、第四和第九的 Question AI、Talkie 以及 Poly.ai。

华尔街日报也援引知情人士消息称,零一万物通过一家新加坡公司在中国境外测试了两个 AI 聊天机器人,分别名为 Monaland 和 Shado。

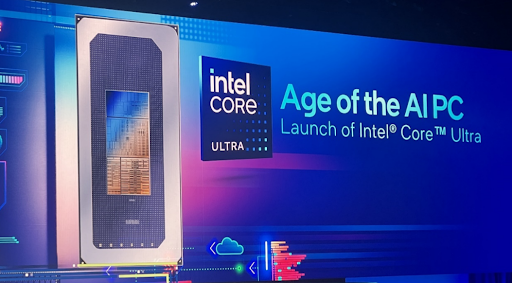

此外,一些行业专家预计,能够在智能手机和笔记本电脑上运行的较小规模模型,或称为「边缘 AI」,将成为下一个改变游戏规则的关键因素。

「今年是小模型的时代,」纽约大学法学院兼职教授马文斯顿表示。他指出,使用较少训练数据的小模型运行速度更快,尤其适用于特定功能的实时应用。

有消息称,AI 独角兽公司百川智能正在与高通合作,将一个较小的大语言模型集成到其中国的 AI PC 中。三星也在其中国的智能手机中集成了来自百度和字节跳动的模型。

Bernstein Research 的分析师范波表示,「专注于边缘 AI 并不意味着降低技术要求,而是转向一个不依赖高计算能力的领域。

历史不会重复,但会经常押韵。

从法拉第在 1831 年发现电磁感应现象,到制造第一台电动机和发电机,再到白炽灯的发明,已是接近 50 年后。

而当下我们需要做的就是尽快找到属于 AI 时代的白炽灯。